Die Google Webmaster Tools wurden um ein weiteres Werkzeug erweitert, dem Robots.txt Tester.

Wie es der Name sagt, kann man mit dem Robots.txt Test Tool die Funktion der Robots.txt prüfen.

Was die Robots.txt ist und wie man sie richtig erstellt, hatten wir im OnPage Friday zum Thema Robots.txt, Sitemap.xml und GoogleBots.

Was kann der neue Robots.txt Tester?

Der Tester für die Robots.txt hat folgende Funktionen:

- Er zeigt Fehler und Warnungen für die Robots.txt an.

- Man hat die Möglichkeit verschiedene URLs zu prüfen.

- Werden Sie blockiert?

- Werden sie nicht blockiert?

- Die URLs kann man mit den verschiedensten Google Bots prüfen:

- Natürlich mit dem Googlebot.

- Mit dem Newsbot.

- Mit dem Google- Bilderbot.

- Auch mit dem Videobot.

- Dem Smartphonebot.

- Mit dem Google- AdsBot.

- Und natürlich dem Mediapartners- Bot

- Außerdem wird angezeigt, wann Google die Letzte Version der Robots.txt geladen hat.

Warum gibt es den Robots.txt Tester?

Den Robots.txt Tester stellt uns Google zur Verfügung, dass wir noch einfacher die Robots.txt auf Fehler prüfen können und das für alle Bots. Um festzustellen, ob eine Webseite von Google gecrawlt werden kann oder nicht, ist es natürlich sinnvoll, ein Tool von Google zu verwenden.

Mit der Robots.txt werden immer wieder Fehler gemacht, die ein Ranking bei Google verhindern. Ein klassisches Beispiel ist Folgendes:

Es wird versucht jedem Robot jede Seite zu crawlen, also nichts zu verbieten. Setzt man hier ein Zeichen falsch, verbietet man allen Robots alle Webseiten zu crawlen.

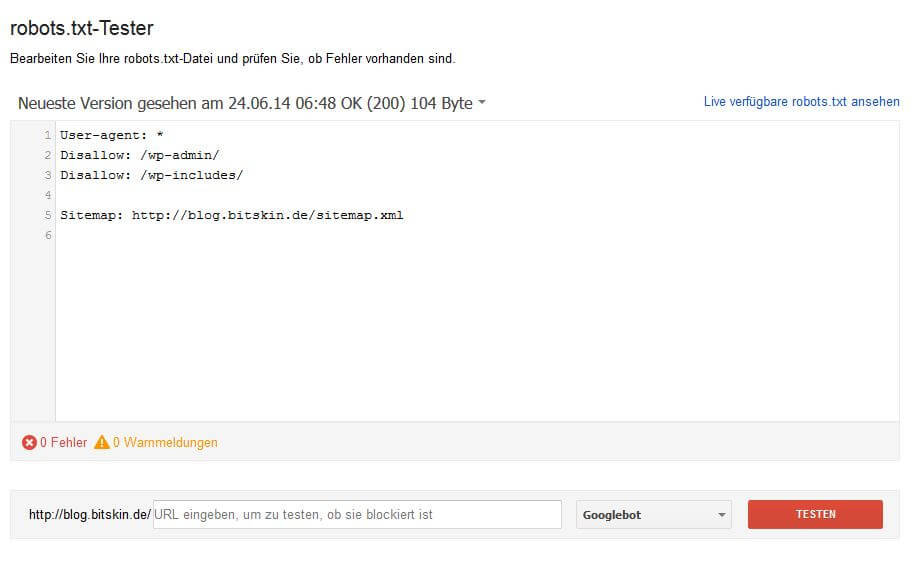

So sieht der Robots.txt Crawler aus:

Schlicht und einfach ist das neue Robots.txt Test Tool von Google sehr leicht zu verstehen.

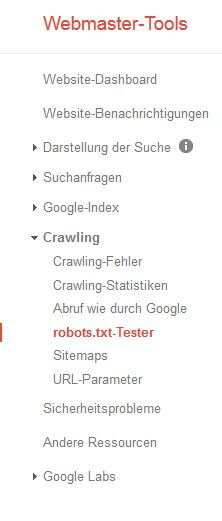

Wie man im Bild oben sehen kann, ist es auch sehr leicht zu finden.

Jetzt ist es also leichter herauszufinden, ob meine wichtigen Seiten von Google gecrawlt werden können, oder ob ich es der Suchmaschine verbiete.

Wer weitere offizielle Informationen zur Robots.txt sucht, der sollte sich die Google Webmaster Help Page ansehen.